Die Forschung in der Informatik an der Universität Heidelberg erstreckt sich über eine Vielzahl von Arbeitsgruppen und interdisziplinären Projekten, von denen einige weiter unten exemplarisch aufgelistet sind. Beachten Sie auch, dass die Abschlussarbeiten in der Informatik ein gutes Bild von den aktuellen Projekten der verschiedenen Arbeitsgruppen widerspiegeln.

Im Folgenden sind einige Kernforschungsgebiete aufgeführt, die auf den Seiten der Fakultät für Mathematik und Informatik detaillierter dargestellt werden, u.a.

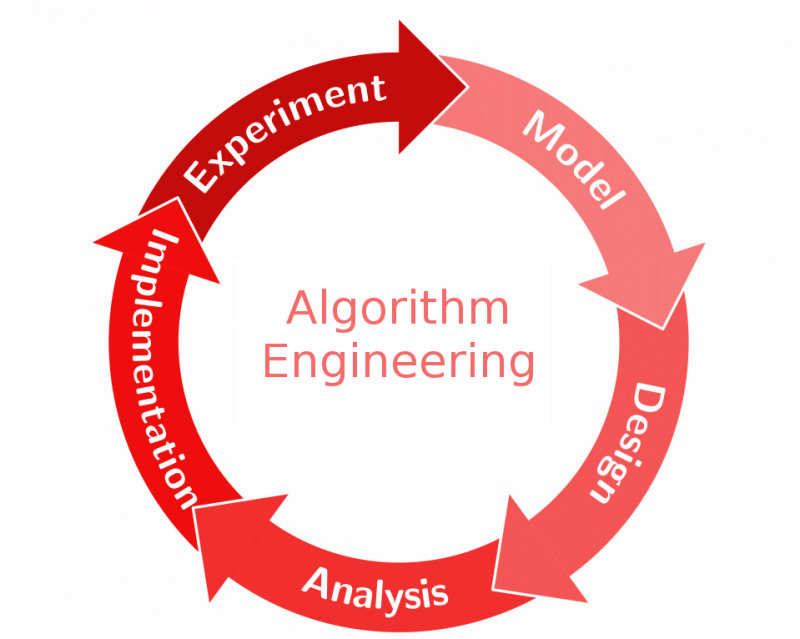

In der modernen Welt sind wir von Algorithmen umgeben. Jede Aufgabe, die ein Computer ausführt - sei es die Verarbeitung von Bildern, die Verbindung zum Internet oder die Verwendung einer Kreditkarte - erfordert eine präzise Schritt-für-Schritt-Anleitung, die ein Computer verstehen kann. Diese Anleitung ist ein Algorithmus. Aber Algorithmen sind nicht nur für Computer gedacht. Schon vor mindestens 3600 Jahren wurden Algorithmen in der Mathematik verwendet und auch heute noch sind viele mathematische Beweise algorithmisch aufgebaut. Es gibt drei Hauptfragen, die man sich zu einem Algorithmus stellen kann: Gibt es einen Algorithmus, der ein bestimmtes Problem löst? Wenn ja, wie viele Ressourcen (Rechenleistung, Kommunikation, Arbeitsspeicher, Speicherplatz) benötigt er? Und wie schnell ist er, wenn er auf einer bestimmten Hardware ausgeführt wird? >> mehr

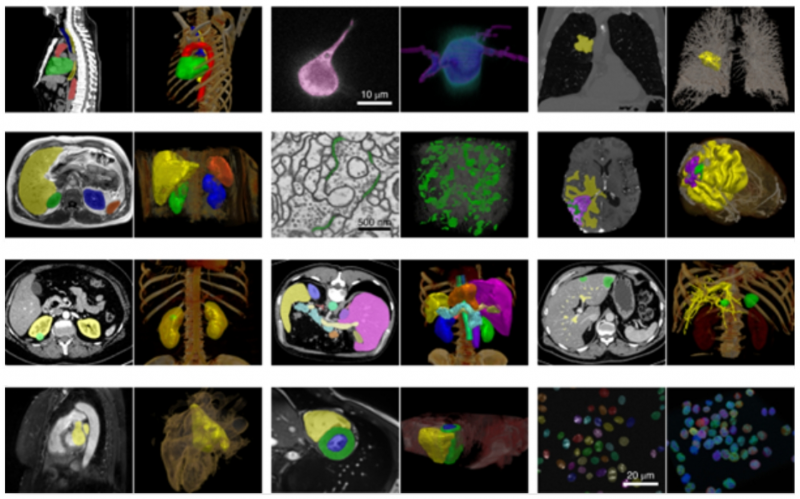

Maschinelles Lernen ist die Wissenschaft der Extraktion von Wissen aus Daten und Erfahrungen. Die Bildverarbeitung wiederum ist eine ihrer wichtigsten Anwendungen. Deep Learning, also maschinelles Lernen mit großen künstlichen neuronalen Netzen, hat in jüngster Zeit große Erfolge bei der Lösung anspruchsvoller realer Aufgaben wie der Übersetzung natürlicher Sprache, automatisierten Spieleprogrammen und der medizinischen Bildverarbeitung erzielt. Die Erweiterung des Anwendungsbereichs Deep Learning und die Gewährleistung seiner Vertrauenswürdigkeit gehören zu den hochaktuellen Themen in der Informatik und der angewandten Mathematik. Zu diesem Zweck wird derzeit erforscht, wie man automatisch gute Netzwerkarchitekturen für ein bestimmtes Problem definiert, wie man auch bei spärlichen Datenmengen gut lernen kann, wie man die Vertrauenswürdigkeit der Ergebnisse bewertet, wie man die Prognosegenauigkeit mathematisch garantieren kann und wie man dem Menschen die Entscheidungsprozesse von Deep Networks erklären kann. >> mehr

Im Fokus von Software Systeme und Engineering stehen die Struktur, das Verhalten, die Qualität komplexer IT-Systeme in unterschiedlichen Kontexten sowie Entwicklung, Betrieb und Nutzung dieser Systeme.

Der Schwerpunkt in Heidelberg sind die Qualitäten IT-Sicherheit, Zuverlässigkeit, Wartbarkeit und Gebrauchstauglichkeit. Im Bereich IT-Sicherheit entwickeln wir Methoden zur Modellierung and Evaluierung von Angriffen, die die Entwicklung von Gegenmaßnahmen unterstützen, z. B. Sicherheitmodelle, Kryptografie, Zugangsmechanismen, digitale Identitäten oder Penetrationstests. Im Bereich Wartbarkeit und Gebrauchstauglichkeit entwickeln wir Methoden des Requirements Engineering und des Rationale Management um qualitativ hochwertige Software Engineering Prozesse über den gesamten Produktlebenszyklen zu gewährleisten. Weiterhin fokussieren wir auf parallel und verteilte Systeme in Bezug auf skalierbare Datenanalyse, KI-basierte Methoden zur Unterstützung der Programmierung sowie Softwarezuverlässigkeit. >> mehr

Durch kontinuierliche Fortschritte in der Sensortechnologie sowie bei der Instrumentierung von Experimenten und Simulationen erleben wir einen enormen Anstieg der Menge und Komplexität der in verschiedenen Anwendungsbereichen gesammelten Daten. Während bereits das Management solcher „Big Data“ oft eine Herausforderung darstellt, sind robuste und effiziente Methoden zur Analyse und Exploration solcher Daten heute einer der zentralen Forschungs- und Entwicklungsbereiche, die darauf abzielen, neue Erkenntnisse aus Daten zu gewinnen und dadurch Innovationen und Geschäftsmodelle voranzutreiben.

Die Entwicklung und Anwendung von Datenanalyse- und Explorationsmethoden ist typischerweise eng mit der Anwendungsdomäne verbunden, in der die Daten erzeugt und verwendet werden. In Heidelberg findet dies in einem stark interdisziplinären Umfeld statt, in dem Forschungsgruppen unterschiedlicher Disziplinen – von den Naturwissenschaften wie Medizin, Biologie und Physik bis hin zu den Sozial- und Geisteswissenschaften – mit Mitgliedern unserer Forschungsgruppen zusammenarbeiten. Der Fokus dieser Kooperationen für die Gruppe Datenanalyse liegt vor allem in den Bereichen der visuellen Datenanalyse und der Textanalyse. >> mehr

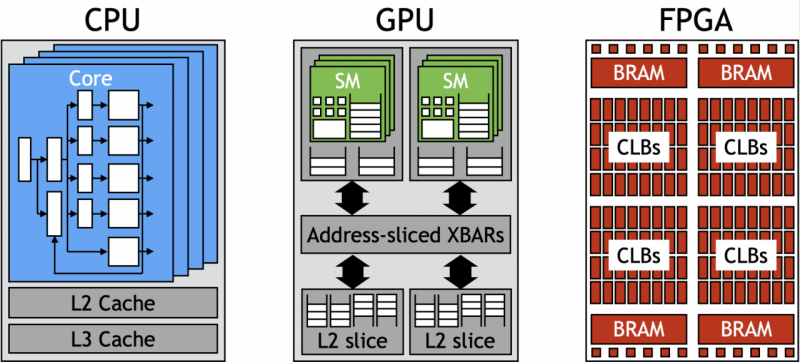

Die Technische Informatik beschäftigt sich mit der Funktionsweise, dem Aufbau und der Nutzung von Hardware zur Erfassung und Verarbeitung von Daten. Durch ein genaues Verständnis der elementaren Bauteile, von Funktionsgruppen, Chips, Rechnerarchitekturen und großen, heterogenen Rechnersystemen können – durch 'hardwarenahe Programmierung‘ – Algorithmen an die Stärken und Schwächen der verwendeten Hardware angepasst und so in ihrer Rechenleistung und Energieeffizienz deutlich gesteigert werden. Für spezielle Computing-Anforderungen werden anwendungsspezifische Hardware/Software Kombinationen und optimierte Systemkonfigurationen eingesetzt.

Die Technische Informatik in Heidelberg (ZITI) ist vernetzt mit vielen Forschungsbereichen der Universität, in denen Daten erfasst werden oder rechenintensive Aufgaben zu bewältigen sind. Für Problemstellungen im Bereich von Sensorik oder Datenkommunikation hat ZITI die Kompetenz, Mikrochips von Grund auf neu zu entwerfen und in Betrieb zu nehmen. Datenkommunikation verursacht oft einen Großteil des Energieverbrauchs, dies wird auf der Hardware-Ebene, durch hardwarenahe Programmierung und angepasste Systemarchitekturen behandelt. Neben der effizienten Programmierung moderner Prozessoren werden verschiedene Koprozessoren (FPGAs, GPUs, ML Prozessoren) am ZITI betrieben, um deren spezifische Stärken auszunutzen und Methoden und Arbeitsflüsse für höchst effiziente Datenverarbeitung zu erforschen. >> mehr